出现page allocation failure. order:1, mode:0x20解决办法

最近有机器遇到一问题:nginx: page allocation failure. order:1, mode:0x20

Pid: 18448, comm: nginx Not tainted 2.6.32-431.17.1.el6.x86_64 #1以下是在百度上找到的信息:dmesg里报出这个信息,然后机器负载开始上升,而实际上用free可以看到还有大量的内存被buffer/cached因此不应该出这个问题才对,我的系统是centos6,上centos的论坛查了一圈,有人回说是内核的bug一个临时解决方案是sysctl -w vm.zone_reclaim_mode=1关于zone_reclaim_mode的定义kernel的文档里描述如下Zone_reclaim_mode allows someone to set more or less aggress ---->>阅读完整内容

Xen出现nf_conntrack: table full, dropping packet.的一些解决调整参数

我们的Centos6 x64_64系统的Xen宿主内核出现了一些日志,相应状况有网络丢包的现象发生。nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dropping packet.

nf_conntrack: table full, dro ---->>阅读完整内容

Xen出现Too many frags以及fatal error; disabling device日志,子系统断网解决办法

Xen有些时候一些GUEST OS系统正常运行中但是网络断了,直接重启后网络又恢复了。

从dmesg里面查看相应的信息发现出现了Too many fragsvif vif-162-0: vifXEN_NAME.0: Too many frags

vif vif-162-0: vifXEN_NAME.0: fatal error; disabling devicegoogle了一下从一些mail list里面找到了解决办法,就是关闭tx和tso以及gso.先查看网卡ethtool -k 网卡运行命令会得到以下返回数据(一些机器返回的结果可能会有出入)[root@node75 ~]# ethtool -k eth0

Features for eth0:

rx-checksumming: on

tx-checksumming: on

tx-checksum-i ---->>阅读完整内容

调整解决ssh连接自动断开问题

一些时候开着的ssh窗口经常自动断开, 有时候是网络状况不够稳定导致,通过调整sshd配置可以缓解一定的状况。sed -i 's/#ClientAliveInterval 0/ClientAliveInterval 15/g' /etc/ssh/sshd_config

sed -i 's/#ClientAliveCountMax 3/ClientAliveCountMax 45/g' /etc/ssh/sshd_config

service sshd restartClientAliveInterval 设置一个以秒记的时长,如果超过这么长时间没有收到客户端的任何数据,

sshd 将通过安全通道向客户端发送一个”alive”消息,并等候应答。

默认值 0 表示不发送”alive”消息。这个选项仅对SSH-2有效。ClientAliveCountMax sshd ---->>阅读完整内容

[kipmi0]进程CPU 100%高占用率解决办法

服务器top进程上进程看到kipmi0经常占用很高的CPU甚至是100%看看专业的说法:

kipmi is supposed to run with low priority. When you say it consumes 70-90% of the CPUs, is that constant (does it still consume the processor when they are other tasks in the process queue that should have a larger slice of the CPU time) or the 70%/90% comes when the machine is idle? A second issue to investigate is whether you have pendin ---->>阅读完整内容

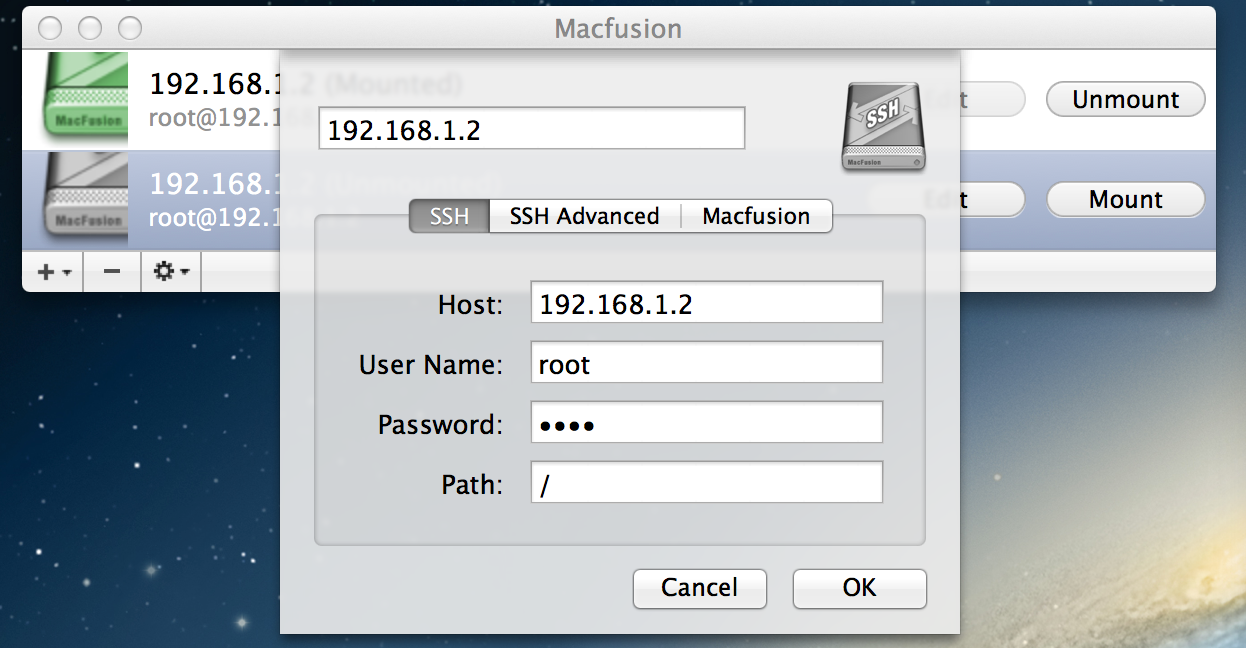

Mac OS X 挂在 ssh与 sftp 到本地

fuse在linux下可以挂载ssh和sftp,在unix的OS X下也是支持的.下面是解决方案:首先我们需要两个软件,OSXFuse和MacFUSE,下载地址https://github.com/osxfuse/osxfuse/downloadshttp://macfusionapp.org/步骤:1、安装 OSXFuse,它为我们提供了对 ssh、sftp文件系统的支持下载 .dmg,挂载之后,运行其中的 .pkg,按照步骤安装,如下图:2、安装 Macfusion,它为我们提供了一个方便挂载 ssh、sftp的界面下载的是 zip包,解压之后得到 .app文件,直接将其拖动到 “应用程序”目录几行啦。然后从 Launchpad中打开它。我的机器上,Macfusion有时候会崩溃,我们还是没使用 sshfs通过命令行来挂载 ssh文件系统。下载地址:https ---->>阅读完整内容

fuse在linux下可以挂载ssh和sftp,在unix的OS X下也是支持的.下面是解决方案:首先我们需要两个软件,OSXFuse和MacFUSE,下载地址https://github.com/osxfuse/osxfuse/downloadshttp://macfusionapp.org/步骤:1、安装 OSXFuse,它为我们提供了对 ssh、sftp文件系统的支持下载 .dmg,挂载之后,运行其中的 .pkg,按照步骤安装,如下图:2、安装 Macfusion,它为我们提供了一个方便挂载 ssh、sftp的界面下载的是 zip包,解压之后得到 .app文件,直接将其拖动到 “应用程序”目录几行啦。然后从 Launchpad中打开它。我的机器上,Macfusion有时候会崩溃,我们还是没使用 sshfs通过命令行来挂载 ssh文件系统。下载地址:https ---->>阅读完整内容 openvz ppp设置

安装好openvz内核后还需要加载ppp的模块才能让guest OS支持pptpcat>>/etc/sysconfig/modules/ppp.modules<<EOF

#!/bin/sh

/sbin/modprobe ppp_async

/sbin/modprobe ppp_deflate

/sbin/modprobe ppp_mppe

EOF

chmod +x /etc/sysconfig/modules/ppp.modules

bash /etc/sysconfig/modules/ppp.modules加载好ppp后还需要对guest os开启,下面已写好了functions直接在终端里面复制粘贴再执行openppp VID就可以了VID查询可以执行vzlist -aopenppp(){

vzctl set $1 --feature ---->>阅读完整内容

Ubuntu系统开启root登陆权限

1.安装openssh

2.sudo -i切换到root用户

3.修改/etc/ssh/sshd_config文件

PermitRootLogin yes

AllowUsers root #网上很多文章都少改了这行

4.重启ssh服务

service ssh restart

Linux CentOS 32位ext3分区解压4G以上ZIP文件方法

如何在UNIX下解压超过4G的ZIP文件安装7za命令:wget http://nchc.dl.sourceforge.net/s ... .65_src_all.tar.bz2

tar -xjvf p7zip_4.65_src_all.tar.bz2

cd p7zip_4.65

make

make install安装完毕,执行解压命令:7za x 解压文件.zip如下:7za x zipfile.zip